COPU会议纪要丨2025.10.21

10月21日陆主席主持召开COPU例会

今天是COPU四个调研团队启动的日子。

一、AIOS团队:

陆主席讲话开头说,研发AIOS,一是要扩大视野,二是要从为单机服务发展到为大模型服务。先不提具体解决方案或不提解决的理论,

先找出国内外涉及AIOS的典型案例,并对其进行点评分析

如:①对Open AI冲击苹果iOS实现AIOS进行分析,②对Red Hat的方案进行分析,③对Android OS的更新方案进行分析,④对谷歌的Fuchsia濒于失败的方案进行分析,⑤对鸿蒙5.0进行分析,⑥对国外的AIOS方案进行分析。

注:

(1)Fuchsia:①微内核Magenta→Zircon ②跨平台③Flutter(UI工具包)

(2)鸿蒙5.0:采用微内核(取代宏内核/多内核)不与安卓兼容

(3)Open AI 2025开发者大会:来自AI的APP&SDK自下而上发展广义OS,Altman说,以ChatGPT取代苹果的操作系统iOS,以及APP生态如何与新型OS(ChatGPT)如何结合,请陈渝老师作出解释和分析、展望。

还有Altman提出的小语音模型等。什么性质?是否是苹果的语言Siri或其放大?容后进行讲解。

二、算力团队

陆主席谈到:我本来邀请华为王震军参加会议,他来电告诉我们,今天他应约率队赴信通院作战略对接。

(1)陈道清汇报2025.9.18华为轮值董事长徐直军发表超节点互联技术是全球最强算力的报告,要求陈道清进一步核实:①单颗昇腾910B芯片的算力,②与Atlas950及960 Super Cluster超节点全连接的高通道仅网络全互联拓扑架构(实现芯片间高度协同)增效如何?③了解卡规模(已知)、总算力(可知)、内存容量(?)、互联带宽(?)等关键指标④了解新型架构和机理

(2)了解单芯片算力及增长情况:①了解CANN核心技术和策略,②了解国内单芯片算力增长情况(兼容CUDA可行吗?),③单芯片如何向多芯片集群算力转移、衔接?④了解Flag OS提升单芯片算力的现实和前景?

会上安泱谈到:算力团队负责研究搜集国内外算力芯片的硬件算力,软件生态和成功案例

三、大模型、多模态团队

大模型列为长期工作,要研究搜集资料的分工及搜集方式。

重点多模态,DeepSeek承认其多模态空白是其缺点

现提供2025.8国内发布的多模态模型评测榜单综合排名作参考:

①字节跳动(闭源)seed1.6,②智谱AI(开源)GLM-4.5,③百度ERNIE,④腾讯hunyuan-T1⑤阶跃星辰Step.3。

四、具身智能体团队

具身列为长期工作,要研究搜索资料的分工及搜集方式。

重点抓好智能体,充分发挥Anna.AI的作用,了解智能体的形式、特点和发展水平,重点协助中兴通讯抓好互动。

团队名单:

1.大模型、多模态团队

团长:谭中意、陈绪、孟迎霞

顾问:刘澎、程海旭

成员:陈伟、鞠东颖、陈越

2.具身、智能体团队

团长:章文嵩、张侃、刘明、孟伟

顾问:陈钟、Anna.ai

成员:袁怿、王珊

3.AIOS团队

团长: 陈渝、宋可为、刘闻欢

顾问:张家驹(Red Hat)

成员:荆琦、李震宁

(鸿蒙如何参加,待议)

4.算力团队

团长: 安泱、陈道清

顾问:朱其罡、王震军、 靳虹博、丁蔚

成员:待定

会上,各团队按照陆主席上周会议纪要要求分别汇报了下一步计划:

AIOS 团队:

陈渝老师谈了:OpenAI在2025年10月6日发布了Apps SDK和AgentKit等,提供了一种面向大模型的新型APP开发方法,希望吸引开发者,成为AI时代的“Android”操作系统。预计这将对传统的桌面操作系统Windows、移动端操作系统Android、iOS带来冲击,也对国内AIOS的发展带来了一些新的思路。

张家驹汇报了红帽对AIOS的思考:面向AI智算中心及边端、车载等场景,打造基于分布式训练推埋的人工智能操作系统,联合业界领先厂商,基于现有工业界事实标准Linux及Kubernetes,结合企业级应用具体实践,重点开发基于vLLM,llm-d等开源项目的平台级解决方案。

算力团队:

算力团队负责研究搜集国内外算力芯片的硬件算力,软件生态和成功案例

1. 全面掌握国内外主流算力芯片的算力,内存带宽,片间通信协议和带宽,节点间的通信协议和带宽,以及算力集群的扩展能力等硬件相关信息;

2. 全面掌握各家算力芯片支持的开发环境和运行环境,支持多少种开发语言,算子库规模,以及支持典型人工智能大模型的种类和数量等软件和生态相关信息;

3. 全面了解各家算力芯片的市场占有情况,以及典型大规模应用案例的实际运行效果和用户反馈。

大模型团队和具身团队也分别做了汇报。

基于 Co-sight 的 AI Agent 分析报告

中兴通讯(ZTE)

1. 摘要

随着大语言模型(LLM)与多模态模型能力的快速提升,AI 智能体(Agent)从单一问答向“持续感知—计划—执行—反思”闭环演进。业界出现以多 Agent 协同、世界模型、长期记忆/短期记忆分层、反思(reflexion)与强化学习信号结合为代表的新范式。Co-Sight 文档提出的一系列技术(Dynamic Context、3-Layer Memory、Act Reflexion、Deep Thinking Twinning、DAG 并行思考等)契合这一趋势,强调对上下文筛选、分层记忆与在线修正机制的工程化实现。总体来看,智能体技术正由能力中心化(大模型)转向系统化(多组件协同、工具使用与安全边界)。

2. 业界整体进展

· 架构趋势

o 单体 LLM 到多 Agent 系统:从以单一强模型直接回答到将规划、执行、监控、工具调用等职责分配给多个功能性 Agent(Planner、Actor、ToolAgent、Verifier 等)。

o 世界模型与内在表征:越来越多工作尝试通过显式世界模型或隐式动态表征(如长期记忆、状态空间模型)来支持多步、多模态交互与因果推理。

o 工具化与可控性:Agent 通过调用检索、代码执行、数据库、搜索引擎、视觉模型等工具扩展能力;“电子围栏”(guardrails)和验证器成为工程上必备的安全与可靠性模块。

o 混合学习范式:微调、指令调优(Instruction Tuning)、强化学习(RLHF / RL with human-in-the-loop)、课程化训练(curriculum learning)组合使用以提升任务对齐性与稳健性。

· 能力提升与评测

o 多步骤推理、长期任务依赖问题逐渐改善,但在复杂组合任务(多工具、多模态、长上下文)下仍有显著差距。

o 社区与业界出现多套综合评测(如文档中提到的 GAIA 或内部benchmark),强调连贯性、鲁棒性、工具亲和和安全性。

· 工程化方向

o 实时监控、执行日志、可解释性与回滚机制成为生产化部署的关键。

o 模型压缩、蒸馏与边缘部署使得部分 Agent 可以在资源受限环境中运行。

3. 主要机遇与价值链

· 商业机遇

o 企业办公助理(自动化工作流、文档理解、表格处理)、客户服务自动化、智能运维、机器人与工业自动化。

o 通过工具链整合(如检索、数据库、自动化脚本),智能体能显著提升生产效率与质量。

· 技术机遇

o 多模态融合(视觉、语音、表格、时序数据)将打开更多应用场景。

o 世界模型与长期记忆结合可带来更强的上下文保持能力与个性化服务。

o 细粒度任务分工与 DAG 并行思考可提升复杂任务求解的效率与可追踪性。

· 合规与安全价值

o 系统化的“电子围栏”与验证模块有助于合规、可审计、降低误用风险。

4. 主要挑战与技术瓶颈

· 上下文管理与动态检索

o 长时序、多来源信息的快速筛选、去噪与优先级排序(类似文档中 Dynamic Context)仍是瓶颈。检索到的信息如何与内在模型高效融合、并在推理时保证不引入噪声,是难点。

· 多 Agent 协同的可靠性

o 多 Agent 协作虽能分担任务,但错误传播、接口不一致、信任度不高,会导致整体性能下降(文档举例两个各自 90%可靠性协同导致 81%)。

· 连贯的长期记忆与可更新性

o 如何区分长期重要知识、短期任务相关信息与临时执行状态,设计有效的读写策略并避免灾难性遗忘,是工程难点。

· 可解释性与审核

o 在多工具调用和复杂决策链路下,如何追溯决策来源、解释模型输出、提供可审计证据链,仍需更多架构支持。

· 评测难题

o 当前 benchmark 往往偏向单次能力评估,缺少对长期、多轮、多模态协同能力的统一、标准评测体系。

· 数据与隐私

o 个性化、长期记忆要求访问用户历史数据,如何在隐私保护与模型能力间权衡是现实限制。

· 计算与成本

o DAG 并行、多 Agent、孪生沙盘等设计会带来更高的推理与训练开销,工程上需要权衡延迟、成本与精度。

5. 典型 AI 智能体方案对比

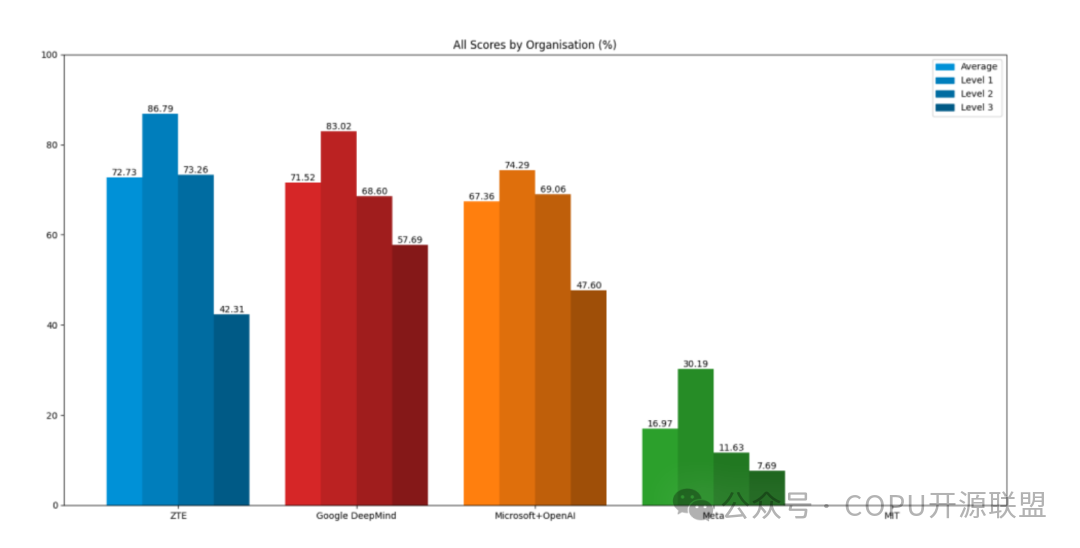

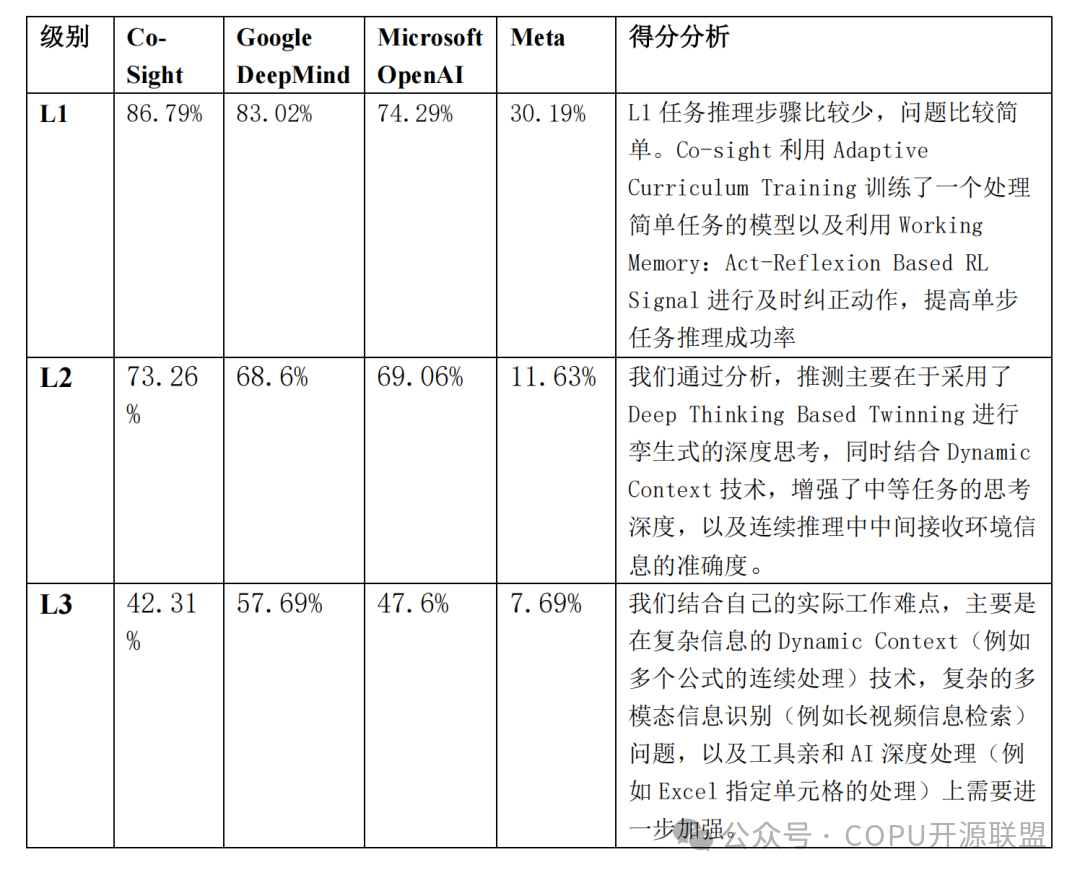

Average(综合表现):ZTE(Co-Sight)平均分 72.73%, Google DeepMind(71.52%),Microsoft+OpenAI(67.36%)。

除以上 GAIA 对比分析以外,还有技术路线的异同。以下以若干代表性技术路线(单体 LLM + 工具、Multi-Agent 体系、Co-Sight 风格分层系统)进行对比

· 单体 LLM + Tools(例如:基于强大 LLM 加检索与工具调用的系统)

o 优势:

*部署较简单,开发迭代速度快。

*单模型统一接口,在很多开放式任务上表现出色。

o 缺点:

*难以做细粒度职责拆分(planner vs executor);面对长任务或复杂工具组合时鲁棒性不足。

*难以引入在线反馈的强化学习循环(虽然可通过外部模块实现)。

· 多 Agent(Planner / Actor / Verifier / ToolAgent)

o 优势:

*职责清晰,便于针对性优化(如单独微调 Planner)。

*容易引入并行化、DAG 结构与多视角思考,提高复杂任务解决能力。

*更易插入监控、审计与纠错环节(如 Verifier / Guardrails)。

o 缺点:

*接口与协议复杂,错误累积和协调成本高。

*需要更多调试与系统工程投入(包括同步、状态管理、消息传递)。

· 分层记忆与课程化训练(Co-Sight 类:Dynamic Context + 3-Layer

Memory + Reflexion RL Signal)

o 优势:

*针对长期/短期信息分层存储和管理,提升长期任务的上下文保持与稳定性。

*课程式训练与奖励信号可使模型在关键任务上更快收敛并获得业务相关性能。

*电子围栏/Act-Reflexion 机制能显著提升执行期间的鲁棒

性与纠错能力。

o 缺点:

*工程复杂度高(需要多种记忆管理、在线检测与奖励设计)。

*训练数据标注、私有评测与坏例构建成本高。

*在极端开放域任务中,分层记忆与课程化策略若设计不当,可能造成过拟合或可迁移性差。

6. 结合 Co-Sight 的技术亮点分析与建议

Co-Sight 体现的关键技术与工程思路在当前 AI agent 发展中很有参考价值,下面逐项分析并给出工程化建议。

· Dynamic Context(动态上下文检索与精炼)

o 亮点:将知识图谱实体抽取、向量检索、关键词+排名、聚类与多

模态精炼结合,最终将 TOP-K 内容传给 LLM 用于推理,符合当前

优良实践。

o 建议:在实现时要注意检索召回与精炼的平衡、避免过度过滤导

致关键证据丢失;引入基于置信度的回退策略(当 top-k 信息置

信低时,触发更宽召回或人工审查)。

· 3-Layer Memory(Model / Short / Working)

o 亮点:将模型级能力训练(Adaptive Curriculum)、任务级反思

(Task-Reflexion)与实时执行校验(Act-Reflexion)结合,是

提升长期任务表现的系统性方案。

o 建议:

*制定清晰的记忆读写策略(何时将短记忆提升为长期记忆、何时清理)。

*评估隐私边界与存储成本,使用差分隐私或可删策略保护用户数据。

*在课程化训练(curriculum)中保留随机性以提升泛化。

· Act-Reflexion & Guardrails

o 亮点:实时电子围栏提供负奖励并促使即时修正,有助于避免累

积错误和提升可靠性。

o 建议:设计多层检测(语义一致性、格式校验、工具调用前后约

束),并保留可审计日志;对非关键时延敏感的任务可允许多次

修正,延迟敏感场景需更轻量速效的纠错策略。

· Deep Thinking Based Twinning(孪生沙盘、多子空间、DAG 并行思考)

o 亮点:通过内部孪生世界做并行假设检验、划分子空间并在 DAG

结构上并行推理,可显著提升复杂任务的求解能力与稳定性。

o 建议:

*在资源有限场景下优先采用筛选式 DAG(只并行重要子节点)。

*将孪生沙盘的模拟结果与实际执行历史对齐,持续校准内在预测模型。

7. 工程落地与实验/评测建议

· 评测体系

o 构建分层评测:单步正确性、多步连贯性、工具调用正确率、恢复/纠错能力、长期记忆保留与隐私合规性。

o 引入对抗样本与长上下文压力测试(例如超长视频或文档检索、多公式连续推导)以检验 Dynamic Context 与记忆系统。

· 训练与数据

o 业务奖励信号(private benchmarks + “坏例”池)要持续维护并用于周期性微调。

o 课程化训练结合线上 A/B 测试,将训练进展与实际业务指标对齐。

· 系统设计

o 模块化与可观测性:各 Agent/模块输出必须带元信息(置信度、来源、时间戳)便于追溯与回滚。

o 容错与降级策略:在关键组件失效时,提供安全降级(如仅检索并返回原文而非生成)以保证最小风险。

o 成本控制:对 DAG 并行或孪生沙盘使用预算限制与动态调度。

8. 结论与未来方向

· 结论

o AI 智能体正在从“能力堆叠”向“系统化设计”转变:单一强模型仍重要,但系统级的分工、记忆分层、在线纠错与工具生态的结合更能满足长期、多模态、生产级需求。Co-Sight 提出的组合(Dynamic Context、3-Layer Memory、Act-Reflexion、Deep Twinning、DAG 思考)在理论与工程上都具有很强的可操作性与落地价值。

本次参会人员:陆首群、张家驹、袁怿、安泱、谭中意、孟伟、陈渝、孟迎霞、张侃、鞠东颖、刘澎(线上)、陈伟(线上)、陈绪(线上)、胡宇(线上)、徐梦江(线上)、程海旭(线上)、王劲男(线上)、靳虹博(线上)、韩宪平(线上)、Anna.AI(线上)。